加了Buff的AI Crypto叙事,「可验证AI」了解一下

编者按:随着最近 AI 在加密货币领域的影响力不断提高,市场开始聚焦于 AI 的可验证性问题。本文中多位加密与 AI 领域的专家分析了去中心化、区块链和零知识证明等技术如何应对 AI 模型可能被滥用的风险,并探讨了推理验证、闭源模型及边缘设备推理等未来趋势。

以下为原文内容(为便于阅读理解,原内容有所整编):

最近为 Delphi Digital 的 AI 月度活动录制了一场圆桌讨论,邀请了四位专注于加密与 AI 领域的创始人,共同探讨了可验证 AI 的话题,以下内容是一些关键要点。

嘉宾:colingagich、ryanmcnutty33、immorriv 和 Iridium Eagleemy。

未来,AI 模型将成为一种软实力,它们的经济应用越广泛、越集中,滥用的机会也就越多。无论模型输出是否被操控,单是感受到这种可能性就已十分有害。

如果我们对 AI 模型的看法变得和对社交媒体算法一样,我们将面临很大麻烦,去中心化、区块链和可验证性是解决这一问题的关键。由于 AI 本质上是一个黑箱,我们需要找到方法使 AI 的过程可证明或可验证,以确保其未被篡改。

这正是可验证推理所要解决的问题,尽管讨论的嘉宾对问题达成了一致,但他们在解决方案上却采取了不同的路径。

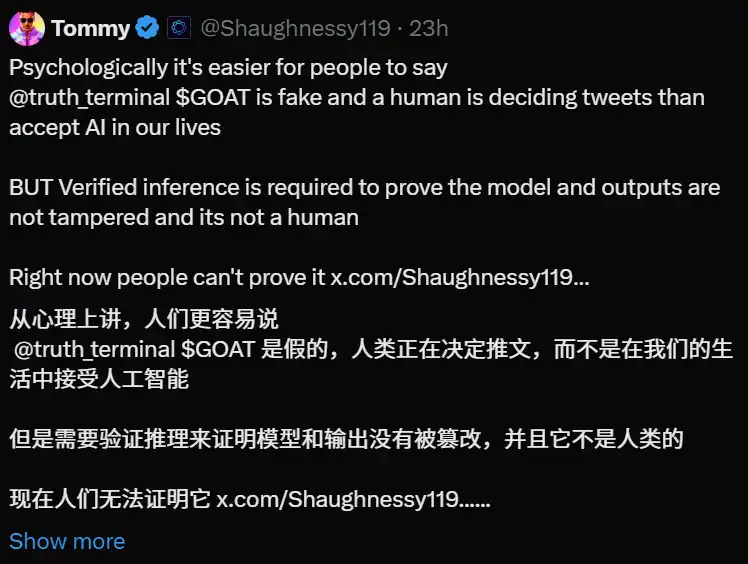

更具体地说,可验证推理包括:我的问题或输入没有被篡改;我使用的模型是我所承诺的那个;输出以原样提供,没有被修改。实际上,这一定义来自 @Shaughnessy119,但我很喜欢它的简洁性。

在目前的 truth terminal 案例中这会有很大的帮助。

使用零知识证明来验证模型输出,毫无疑问,ZK 是最安全的方法。然而,它也带来了一些权衡,计算成本增加了 100 到 1000 倍。此外,并非所有内容都能轻松转换为电路,因此需要对某些函数(如 sigmoid)进行近似处理,并可能会有浮点近似损失。

关于计算开销,许多团队正在努力改进最先进的 ZK 技术,以显著降低开销。尽管大型语言模型体积庞大,但大多数金融应用案例可能相对较小,例如资本配置模型,这样开销就变得微不足道。受信执行环境(TEEs)适合那些对最大安全性要求较低,但对成本或模型大小更为敏感的应用场景。

Ambient 的 Travis 谈到了他们如何计划在一个非常大的分片模型上验证推理,这并不是一个通用问题,而是针对一个特定模型的解决方案。不过,由于 Ambient 仍处于隐秘阶段,这项工作暂时保密,我们需要关注即将发布的论文。

optimistic method,即在推理时不生成证明,而是让执行推理的节点质押代币,若被质疑并发现不当操作则扣除质押代币,这得到了嘉宾们的一些反对意见。

首先,要实现这一点,需要确定性输出,而为了达到这一目标,需要做出一些妥协,例如确保所有节点使用相同的随机种子。其次,如果面临 100 亿美元的风险,多少质押才足以确保经济安全?这个问题最终仍然没有明确答案,这凸显了让消费者选择是否愿意支付完整证明费用的重要性。

关于闭源模型的问题,inference labs 和 aizel network 都能提供支持。这引发了一些哲学上的争论,信任无须需要了解正在运行的模型,因此私有模型是不受欢迎的,与可验证 AI 相悖。然而,在某些情况下,了解模型的内部工作原理可能导致被操控,而解决这一问题的唯一方法有时就是将模型设为闭源。闭源模型如果经过 100 次或 1000 次验证后仍然可靠,尽管无法访问其权重,这也足以让人产生信心。

最后,我们讨论了由于隐私、延迟和带宽等问题,AI 推理是否会转向边缘设备(如手机和笔记本电脑)。大家达成的共识是,这种转变正在到来,但还需要几次迭代。

对于大型模型来说,空间、计算需求和网络要求都是问题。不过,模型正在变得更小,设备也越来越强大,因此这种转变似乎正在发生,只是还没有完全到来。然而,当前如果能够使推理过程保持私密,那么我们仍然可以获得本地推理的许多好处,而不会面临失败模式。

「原文链接」